V-SLAM과 EndToEnd Driving을 결합한 카메라 기반 자율주행 시스템 개발

본 프로젝트는 Visual SLAM과 End-to-End Driving 기술을 결합하여 자율주행 소프트웨어 성능을 개선한 연구이다. 카메라를 활용해 환경을 인식하고, 주행 경로와 속도를 결정하는 과정을 학습시켜 실제 도로 주행을 수행했다. 이를 통해 딥러닝 기반 자율주행 기술의 성능 한계를 극복하고 발전 가능성을 확인했다.

교내에서 자율주행하는 모습

프로젝트 목표

이 프로젝트의 목표는 카메라를 기반으로 한 자율주행 소프트웨어를 개발하는 것이었다. Visual SLAM을 활용해 차량의 위치를 추정하고, End-to-End Driving 기술을 통해 주행 결정을 자동화하도록 구현했다. 이를 통해 실제 환경에서 자율주행이 안정적으로 수행될 수 있도록 하는 것이 주된 목적이었다.

내용

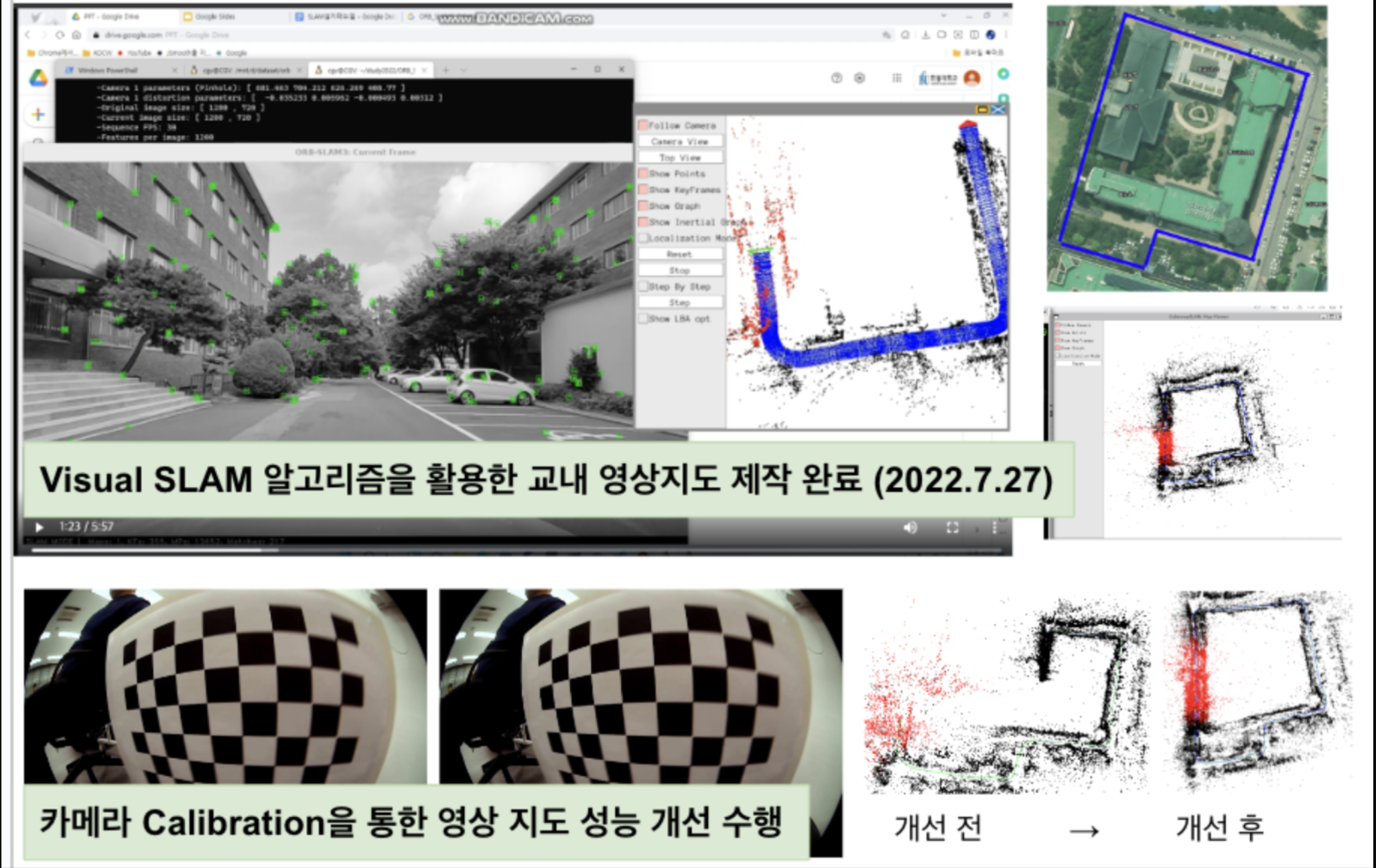

실험에서는 차량에 여러 대의 카메라를 장착하여 주변 환경을 인식하고, Visual SLAM으로 위치를 추정했다. 이후 End-to-End Driving 기술을 활용해 방향 전환과 속도를 결정하도록 학습시켰다. 이러한 과정을 통해 실외 약 560m 구간에서 98%의 주행 성공률을 달성하였으며, 프로젝트 대회에서 최우수상을 수상했다.

문제와 해결 과정

진행 과정에서 가장 큰 문제는 학습 데이터의 부족으로 인한 딥러닝 성능의 한계였다. 데이터 양이 늘어나면 학습 성능이 향상되지만, 실제 주행 환경에서는 데이터 수집에 제약이 있었다. 이를 해결하기 위해 정상적으로 주행한 데이터 시퀀스 외에도 차선 이탈 후 복귀하는 데이터 시퀀스를 추가로 확보했다. 이를 통해 학습 데이터의 다양성을 확보하여 모델의 일반화 성능을 개선할 수 있었다.

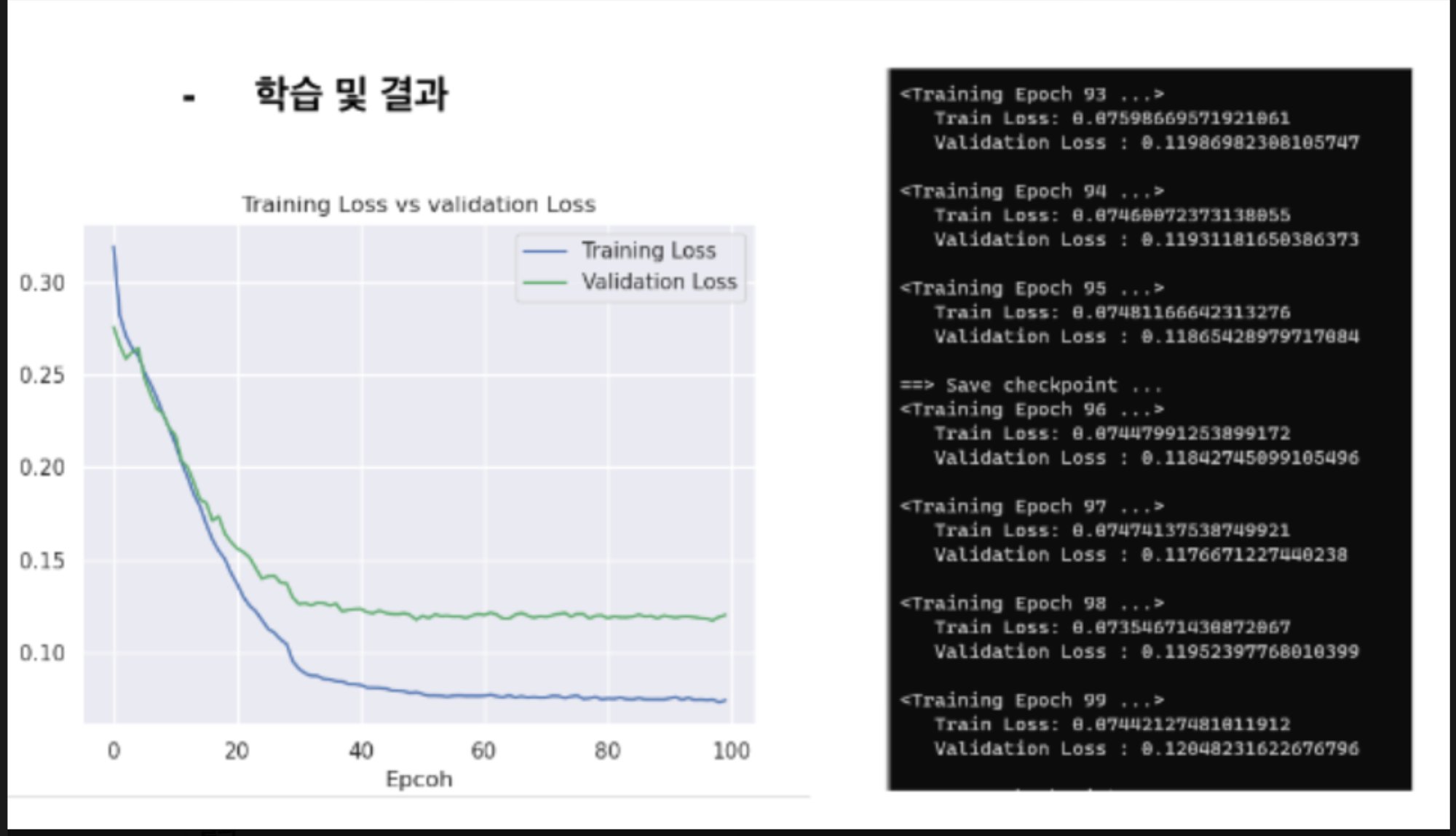

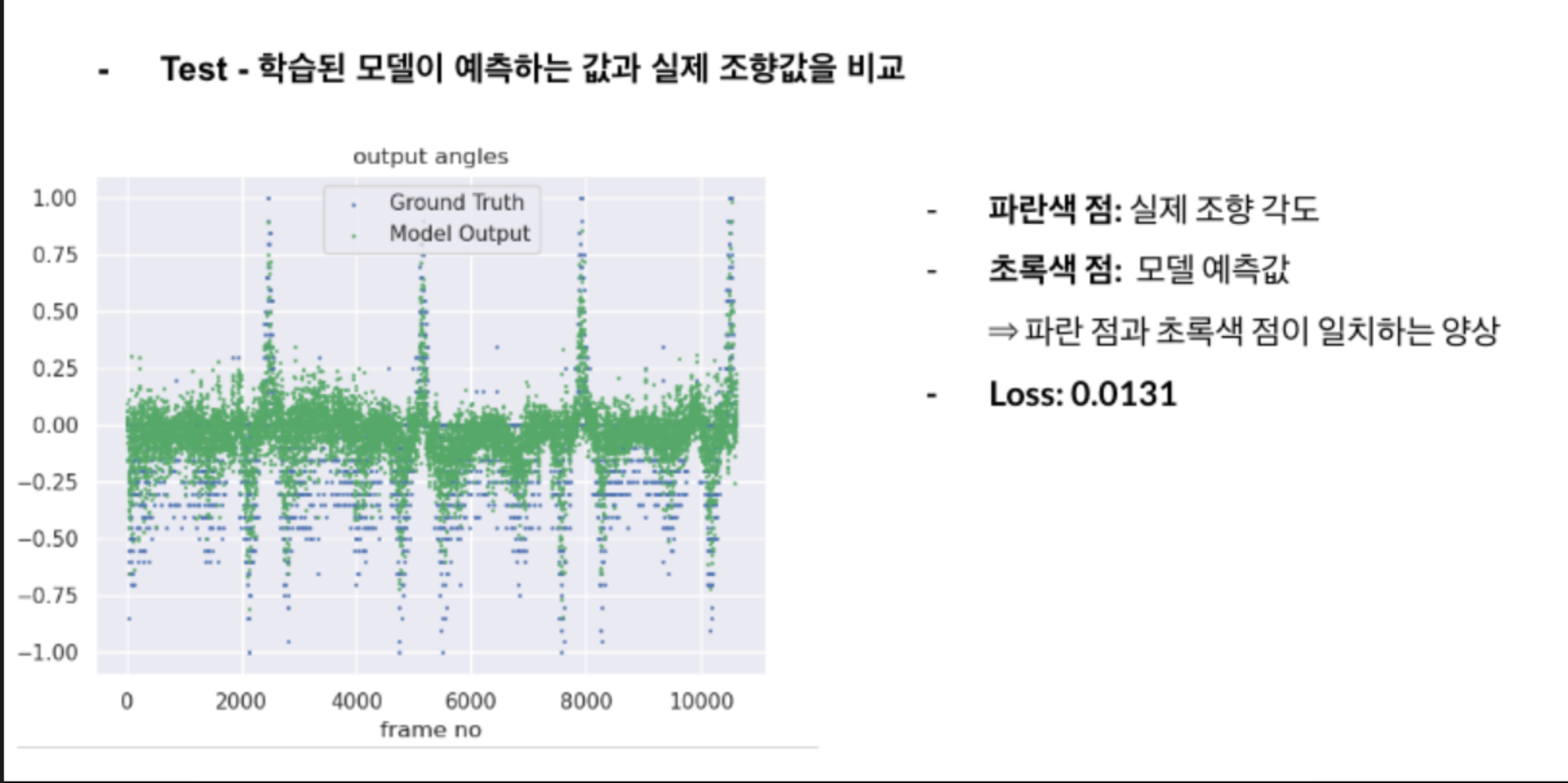

결과

보강된 데이터셋을 활용해 학습한 모델은 초기 80% 수준의 주행 성공률보다 크게 향상된 98%의 성공률을 기록했다. 실외 환경에서 안정적인 주행을 달성하였고, 이를 기반으로 프로젝트 대회에서 최우수상을 수상했다. 본 연구는 데이터 확장이 자율주행 성능 개선에 핵심적이라는 사실을 실험적으로 입증했다.

역할

본 프로젝트에서 카메라 기반 Visual SLAM 시스템을 설계하고, End-to-End Driving 학습 데이터 수집과 전처리를 주도했다. 또한 학습된 모델을 TensorRT로 최적화하여 임베디드 환경에서도 동작할 수 있도록 구현했다. 주행 실험을 통해 결과를 검증하고, 성능 개선 방법을 제시하는 역할을 맡았다.

기타 자료

프로젝트 설명

홍보영상